要从根本上理解 epoll,我们必须跳出 API

的表象,深入到操作系统内核的数据结构和中断处理机制中。

一句话总结 epoll

它将 I/O 处理模式从 "同步轮询 (Synchronous Polling)"彻底转变为 "异步事件驱动 (AsynchronousEvent-Driven)",并将文件描述符(FD)集合的管理权从 "用户态"移交给了 "内核态" 以实现状态持久化。

为了讲清楚,我们把它拆解为三个维度:核心痛点(为什么要有它)、内核架构(它长什么样)、工作流程(它是怎么跑的)。

1. 核心痛点:O(N) 的线性复杂度瓶颈

在 epoll 出现之前(Linux 2.6 之前),网络编程主要依赖

select 或

poll。从计算机体系结构角度看,它们存在一个致命的无状态(Stateless)设计缺陷。

select/poll

模型要求用户每次发起系统调用时,必须将所有需要监控的 FD

集合传递给内核。内核的处理逻辑如下:

- 全量拷贝:将用户态的 FD 数组完整拷贝到内核态。

- 全量遍历:内核必须线性遍历这个 FD 数组,逐个检查对应的硬件设备状态。

- 全量返回:如果发现有就绪事件,或者超时,内核再将修改后的 FD 状态位图拷贝回用户态。

这种方式有以下弊端:

- 上下文切换开销:在高并发场景下(例如 10 万连接),每次调用都要在用户态和内核态之间传递巨大的数据块。

- CPU 算力浪费:时间复杂度为 \(O(N)\)。即使 10 万个连接中只有 1 个活跃,内核也必须检查完所有 10 万个状态。随着 \(N\) 的增加,系统性能呈线性下降趋势。

于是就出现了 epoll,epoll

具有以下特点:

- 效率高: 相较于

select和poll,epoll可以更高效地处理大量的并发连接。select和poll的效率随着监视的文件描述符数量增加而线性下降,而epoll则不会因为监视的文件描述符数量增加而显著降低效率。 - 扩展性好:

epoll使用一种称为事件通知的机制,只会处理那些真正发生了事件的文件描述符。这意味着系统不必重新检查所有文件描述符,从而大大减少了不必要的 CPU 开销。 - 支持边缘触发和水平触发:

epoll支持Edge Triggered和水平触发Level Triggered两种模式。边缘触发模式只在文件描述符状态改变时才通知应用程序,适用于非阻塞 I/O;而水平触发模式则在有事件可读或可写时都会通知应用程序,更容易使用但效率略低。

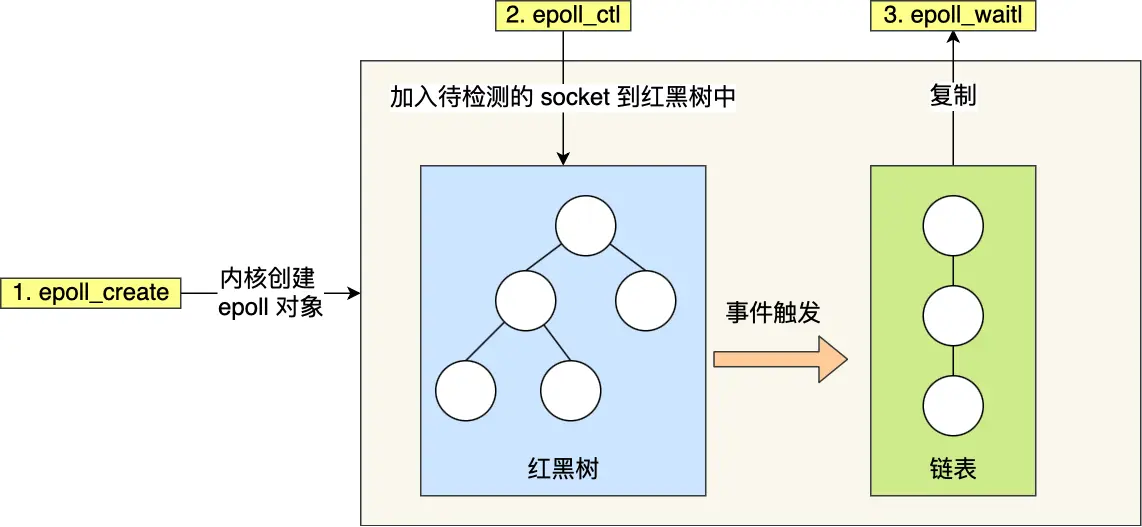

2. 内核架构:红黑树与就绪链表

epoll

的核心改进在于它在内核中维护了一个持久化的上下文(Context)。当你调用

epoll_create 时,内核会在内存中分配一个

eventpoll 结构体,它包含两个核心数据结构:

2.1 红黑树 (Red-Black Tree) —— 监控集合的静态存储

- 作用:存储所有通过

epoll_ctl注册的 FD 及其对应的epitem(封装了事件类型等信息)。 - 设计理由:

- 红黑树提供了稳定的查找、插入和删除性能,时间复杂度为 \(O(\log N)\)。

- 它实现了 IO 多路复用的状态保持。用户态不需要每次都重新传递 FD 列表,内核直接在树中维护。

2.2 双向链表 (Double Linked List) —— 活跃集合的动态缓冲

- 作用:仅存储当前处于就绪状态的

epitem引用。这是一个“活跃事件队列”。 - 设计理由:

epoll_wait的核心逻辑简化为:检查该链表是否为空。- 如果不为空,将链表节点弹出并复制到用户态。

- 复杂度质变:获取就绪事件的时间复杂度从 \(O(N)\) 降低为 \(O(K)\),其中 \(K\) 为当前活跃连接数。在海量并发空闲连接的场景下,效率与总连接数无关。

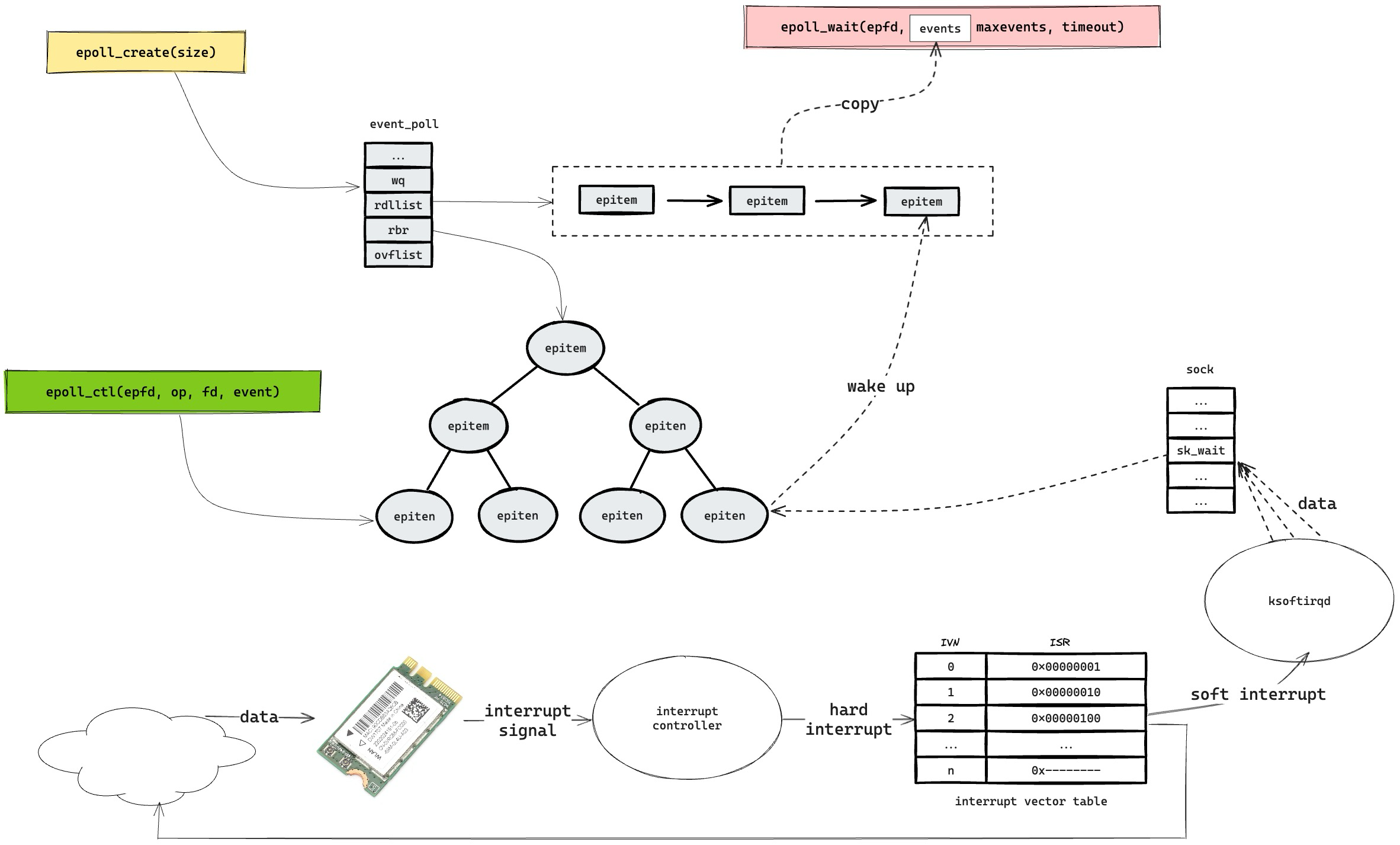

3. 工作流程:中断驱动与回调机制

红黑树中的静态节点如何流转到就绪链表中?这依赖于底层的硬件中断与等待队列回调机制。

- 实例初始化 (epoll_create):

- 内核分配 eventpoll 结构,初始化红黑树根节点和就绪链表头指针。

- 事件注册 (

epoll_ctl+EPOLL_CTL_ADD):- 内核在红黑树中插入新的节点。

- 关键操作:内核查找到该 FD

对应的底层文件对象(Socket),并在该对象的等待队列(Wait

Queue)中注册一个特定的回调函数:

ep_poll_callback。这一步建立了硬件事件与epoll实例的联系。

- 阻塞等待 (

epoll_wait):- 检查

eventpoll的就绪链表是否为空。 - 若为空,将当前进程(或线程)挂起,进入睡眠状态(调度出 CPU),直到超时或被唤醒。

- 检查

- 中断触发 (数据到达):

- 网卡接收数据 -> CPU 响应硬件中断 -> DMA 拷贝数据到内核缓冲区 -> TCP 协议栈处理。

- 当数据写入 Socket 接收缓冲区后,协议栈检测到该 Socket

的等待队列非空,随即调用注册的

ep_poll_callback。

- 回调执行:

ep_poll_callback将该 FD 对应的epitem引用添加到eventpoll的 就绪链表 尾部。- 同时,唤醒正在

epoll_wait中阻塞的进程。

- 返回用户态:

- 进程被唤醒,

epoll_wait将就绪链表中的事件复制到用户态内存,函数返回。

- 进程被唤醒,

4. LT vs ET

理解了回调机制后,LT 和 ET 的区别就在于就绪链表的维护策略不同。

4.1 LT 水平触发 (Level Triggered) - 默认模式

- 机制:当

epoll_wait检测到就绪链表中有节点时,会将其报告给用户。如果用户没有读完缓冲区的所有数据,内核在下一次检查时,会重新将该节点加入就绪链表(或者不将其从链表中移除)。 - 特征:状态驱动。只要缓冲区不为空,事件就一直存在。

4.2 ET 边缘触发 (Edge Triggered) - 高性能模式

- 机制:

ep_poll_callback仅在 Socket 状态发生变化(如从"不可读"变为"可读")时触发一次,将节点加入就绪链表。一旦用户通过epoll_wait取走了该事件,除非有新的硬件中断(新数据到达),否则该节点不会再次进入就绪链表。 - 特征:事件驱动。

5. 中断

中断机制是计算机硬件和操作系统核心功能之一,它允许外设或硬件异步地通知

CPU 需要处理某些事件。中断机制的实现并不依赖于类似于 for

循环的轮询检查,而是建立在更为直接和高效的硬件和处理器架构支持之上。

当 CPU 接收到中断信号时,它是通过一套内建于硬件的协调机制来识别和响应中断的。这个过程涉及硬件电路设计、处理器架构和操作系统的中断管理功能。

5.1 中断信号的检测和响应

- 中断请求线(IRQ):外部设备通过连接到处理器的一个特定的硬件线路(IRQ)发送中断信号。这个线路直接与处理器内的中断控制单元(Interrupt Controller)相连。

- 中断控制器:大多数现代计算机系统使用一个或多个中断控制器来管理中断信号。中断控制器的任务是接收来自各种外部设备的中断请求,并将这些请求优先级排序后发送给 CPU。

- 中断向量:当中断控制器接收到一个中断信号后,它会根据中断源确定一个中断向量。这个向量是一个数字,指向中断向量表中对应的入口,该入口包含了处理该中断的中断服务例程(ISR)的地址。

5.2 CPU 如何处理中断

- 当前指令的完成:当 CPU 接收到中断控制器发出的中断信号时,它首先会完成当前执行的指令。这是为了保证程序的状态能够正确保存,从而在中断处理完毕后可以无缝地恢复执行。

- 保存上下文:一旦当前指令执行完毕,CPU 会自动保存当前的程序状态,包括程序计数器(PC)、寄存器和其他必要的状态信息。这些信息通常被推送到当前的栈上。

- 跳转到 ISR:CPU 使用中断向量来访问中断向量表,找到与中断号对应的中断服务例程(ISR)的地址,并跳转到该地址开始执行 ISR。这个过程是自动的,由处理器的内部机制控制。

- 执行 ISR:中断服务例程会执行必要的操作来处理中断,比如读取数据缓冲区、清除设备状态或发送信号等。

- 恢复上下文并返回:一旦 ISR 执行完成,处理器会从栈上恢复之前保存的程序状态,并将控制权返回到被中断的程序,继续执行。